Cet article est paru en décembre 2016 dans la revue Enjeux de l’AQEUS.

Yelle F., Éthier, M.-A. et Lefrançois, D. (2016). Ce qui est visible de l’apprentissage par la problématisation: une lecture critique des travaux de John Hattie. ENJEUX, 12 (3), 35-38. [1]

En 2009, John Hattie publiait Visible Learning, un essai classant notamment différentes méthodes d’enseignement et d’apprentissage, selon ce que des données probantes disaient de l’effet de chacune. Au Québec, le livre a eu tôt fait de connaitre un fort retentissement, tant dans les réseaux sociaux que dans les magazines d’actualité[3] et les journaux[4]. L’ouvrage passe maintenant pour une référence incontournable pour répondre à toutes les questions éducatives: ce serait une véritable bible, voire le Saint Graal de l’éducation (lire notamment le billet de Normand Baillargeon [2014] à cet égard). Son contenu sur l’apprentissage par problème et les conclusions que certains pédagogues, journalistes et politiciens québécois fondent sur les données de Hattie ont attiré notre attention.

Baillargeon, par exemple, classe l’apprentissage par problème dans une catégorie qu’il nomme « ouache » (Baillargeon, 2014). Or, les programmes québécois d’études des sciences sociales reposent sur la problématisation! Si l’inefficacité de cette approche était avérée, cela conduirait à se demander si les choix éducatifs et politiques de la dernière réforme sont issus d’un aveuglement idéologique, d’une erreur scientifique, ou encore d’une fraude intellectuelle. Comme nos lectures et les résultats de nos recherches nous convainquent, au contraire, que l’approche par problème représente un moyen efficace de construire le savoir, nous avons voulu fouiller la question.

Cet article rend compte de nos conclusions et comporte quatre parties. La première explique brièvement en quoi consiste la démarche de Hattie, tandis que la deuxième expose quelques critiques d’ensemble que ce genre de démarche a suscitées. La troisième analyse le cas de l’apprentissage par problème comme tel. La quatrième expose les principales réflexions découlant des observations contenues dans les deuxième et troisième parties de cet article.

La démarche

Visible Learning synthétise près de 800 métaanalyses, composées d’environ 50 000 études portant au total sur des dizaines de millions de personnes. Ces métaanalyses identifient plus d’une centaine de facteurs qui font varier l’apprentissage, telles des méthodes d’enseignement comme l’instruction directe ou des politiques comme la réduction du ratio maitre-élève. Hattie classe ces facteurs selon l’ampleur de leur effet (positif ou négatif) sur l’apprentissage des élèves. Il représente cette ampleur par une cote, laquelle permet de comparer l’efficacité des facteurs. Cette première partie de notre article explique le sens que l’auteur donne à cette cote.

La cote utilisée est un indicateur d’efficacité situé sur un continuum, où le zéro (0) correspond à un élément (technique, approche, mesure, etc.) qui n’a pas d’effet sur la réussite scolaire ou l’apprentissage. Un effet de 1 signifie que les apprenants réussissent avec 50 % plus d’efficacité et de rapidité que dans la zone 0. Tout au long du livre, l’indicateur repère est +0,40. Cette cote agit comme un point de bascule entre les méthodes dites efficaces et inefficaces. Elle a été déterminée en fonction de la moyenne de tous les effets recensés dans les métaanalyses.

L’importance des étiquettes et du cadre conceptuel

Cette démarche génère deux sortes de critiques. Le premier ensemble regroupe des considérations avant tout émises par des experts en méthode quantitative. Le deuxième s’intéresse plus directement à la définition du problème et aux principes de la démarche. Avant de nous concentrer sur celles-ci, évoquons d’abord les premières critiques. Selon certains auteurs, produire un indice permettant de fixer un « seuil de passage » arbitraire enverrait au lecteur un message simpliste et le fourvoierait, notamment en sous-estimant les différences entre les groupes d’élèves (Snook, Clark, Harker, O’Neill et O’Neill, 2010). D’autres considèrent que le travail de Hattie serait truffé d’erreurs (Ollie Orange 2, 2014). D’aucuns le citent même en exemple du manque de rigueur statistique des recherches en éducation. Ils dénoncent la malléabilité de ces recherches, laquelle paverait la voie aux politiciens voulant récupérer idéologiquement la production scientifique et la transformer en slogans (Bergeron, 2016) – la résolution-cadre 4 en éducation (adoptée par le Parti libéral du Québec, lors de son Conseil général des 14 et 15 mai 2016) pouvant illustrer cette tendance. D’autres encore soulignent que le travail de synthèse d’une métaanalyse (et, à plus forte raison, d’une mégaanalyse), même bien réalisé, ne s’intéresse qu’aux résultats quantitatifs (ce qui exclut les résultats des recherches qualitatives) et implique une sous-estimation du biais de publication[5]. Nous laissons les experts des statistiques préciser les critiques méthodologiques de ce premier type. L’autre catégorie nous regarde davantage.

La suite de cette deuxième partie de notre article résume certaines des critiques plus attachées aux fondements de la démarche de Hattie: le flou de son cadre conceptuel et le manque d’information concernant les critères retenus pour la sélection des études. Illustrons d’abord ce dont il est question. Le patient qui se procure des médicaments à la pharmacie présume que l’étiquette apposée au flacon correspond au contenu de celui-ci. Le lecteur d’un essai en démographie tient pour acquis que la définition des unités d’observation (comme emploi, ethnie, famille, immigrant, ménage, travailleur, violence) dont il traite a fait l’objet d’un grand soin et d’un usage continu. Les historiens qui caractérisent différemment « absolutisme », « fascisme », « fief », « Occident », « réforme », « révolution industrielle » ou « totalitarisme », par exemple, aboutissent à des questions de recherche, à des critères d’inclusion et d’exclusion des traces à collecter et à traiter (une base de données), puis à des interprétations différentes. L’ouvrage « Historiographies, I : concepts et débats » (Delacroix, Dosse, Garcia et Offenstadt, 2010) témoigne, dans le domaine de l’histoire, de l’importance de ces débats autour du sens des concepts disciplinaires.

En éducation, si un chercheur distingue, par exemple, l’enseignement par projet, le travail coopératif et le travail en équipe, tandis que d’autres chercheurs ne les distinguent pas ou les délimitent autrement, comparer ces résultats sera difficile. Il sera en outre ardu de localiser et filtrer en toute rigueur les résultats qui doivent être inclus (ou non) dans la métaanalyse. Il sera, enfin, impossible de savoir sur quoi porteraient les moyennes obtenues. Il faut donc définir théoriquement les principaux concepts à l’étude et s’assurer d’établir des critères précis et univoque d’inclusion et d’exclusion. On rencontre la même embuche lorsqu’on tente de comprendre comment l’auteur a choisi les études portant par exemple sur l’apprentissage par problème. Le vocable qu’on retrouve est général, car il compile un grand nombre de recherches, portant sur différentes matières scolaires. Notons à ce sujet que Hattie relève des variances entre les différentes matières scolaires, ce qui commande encore plus de circonspection dans l’évaluation des indicateurs attribués aux différentes approches.

C’est pourquoi il est crucial de savoir à partir de quels critères Hattie a choisi et classé les métaanalyses retenues et comment celles-ci étaient elles-mêmes constituées. Comment les auteurs des 800 métaanalyses compilées dans Hattie (2009) définissent-ils, par exemple, les différentes approches par problème? En d’autres mots, à quoi les étiquettes qu’ils accolent aux concepts qu’il mobilise correspondent-elles?

Quant aux concepts de désirabilité et d’efficacité à partir desquels il faut situer ces approches, ils sont eux-mêmes empreints d’enjeux épistémologiques et idéologiques. Que signifient-ils? En fonction de quels types de savoir une méthode est-elle désirable? En quel sens est-elle efficace? Que permet-elle d’atteindre?

Or, l’ouvrage de Hattie ne contient pas de renseignement sur ces facteurs importants ou, lorsqu’il en donne, il le fait de manière trop générale. Ce flou empêche les lecteurs de juger par eux-mêmes de la stabilité des variables dites importantes, de leur variance ou des critères et des méthodes de leur sélection. Le manque de clarté dans les critères retenus pour la sélection des études pose donc un problème.

Les approches prônant la problématisation sont-elles inefficaces?

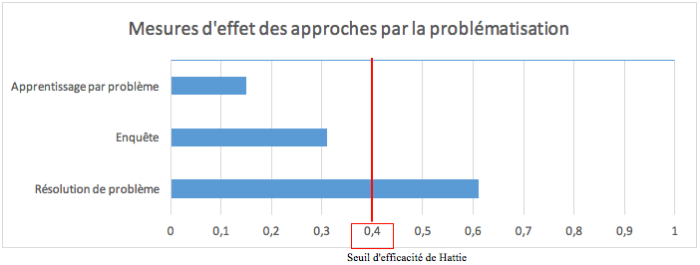

Les analyses que Hattie (2009) propose des approches prônant la problématisation ont suscité notre curiosité envers ses travaux. Pour l’auteur, la problématisation comporte trois catégories dont deux ne se trouvent pas dans la « zone de désirabilité » qu’il a définie (au-dessus de +0,40). Cette partie de l’article s’intéresse à ses analyses de trois méthodes d’enseignement: l’apprentissage par problème, l’enquête et la résolution de problème. (Vous pouvez consulter les données brutes de Hattie à cette adresse[6].) Nous examinerons plus finement ce que l’auteur dit de chacune de ces approches, à tour de rôle.

Notons avant tout que l’ouvrage ne comporte pas d’explication concernant la division qui est proposée des méthodes d’enseignement et d’apprentissage par la problématisation. Les courtes définitions que nous résumons à notre tour dans cet article sont tout ce qui nous permet de différencier les trois catégories qu’Hattie utilise, mais nous aurions voulu connaitre les motifs d’une telle division afin d’en comprendre la pertinence. Si ce manque de clarté quant aux concepts utilisés nous préoccupe, nous nous prêtons au jeu et procèderons néanmoins à notre examen des résultats afin d’en tirer nos propres conclusions.

L’apprentissage par problème (+0,15) désigne une approche centrée sur les élèves, dans de petits groupes où l’enseignant n’agirait qu’à titre de guide ou de facilitateur. Les problèmes qu’ils résolvent sont authentiques (donc liés à leur vécu), ils agissent comme moteur de l’apprentissage (ils sont engageants) et c’est à travers leur résolution que les élèves acquièrent de nouveaux savoirs.

Selon les travaux de Hattie (2009), cette méthode est peu efficace, voire contreproductive par rapport à un environnement d’apprentissage traditionnel, lorsqu’il s’agit d’acquérir de nouvelles connaissances déclaratives ou ce qu’il nomme des « savoirs de surface » (entre -0,78 et -0,04).

Par contre, elle s’avèrerait particulièrement efficace pour l’apprentissage de savoirs complexes (« deep knowledge »), comme le développement de compétences et la capacité des élèves à mettre en application ce qu’ils savent (de +0,40 à + 0,66). Il s’agit là d’objectifs poursuivis lorsque l’on vise le développement de la pensée historienne des élèves.

En combinant l’ensemble des métaanalyse dont il dispose, l’auteur en vient à un faible effet de +0,15 pour l’apprentissage par problème, mais ce méta-indicateur ne tient dès lors plus compte des objectifs d’apprentissage poursuivis lors de la mobilisation de cette approche par un enseignant.

En d’autres mots, l’apprentissage par problème n’est évidemment pas une panacée, mais nous pourrions considérer cette méthode comme efficace dans certaines circonstances. C’est notamment le cas lorsque l’objectif poursuivi est d’apprendre comment lire des sources, les contextualiser, les analyser, les comparer, etc. (des procédures que nous associons au « deep knowledge ») et inefficaces si l’objectif est de mémoriser de nouvelles connaissances substantives, comme la liste des empereurs romains.

L’enquête fait meilleure figure (+0,31). Toutefois, elle ne parvient pas à atteindre le seuil de +0,40 qu’établit Hattie. L’enquête est une méthode d’enseignement basée sur le problème dans laquelle l’enseignement est moins centré sur les élèves, car c’est l’enseignant qui définit la situation d’enquête que ceux-ci doivent élucider. Il s’agit d’une situation où les élèves observent, questionnent et émettent des hypothèses sur une situation complexe, avant de mettre en place un protocole d’enquête (appris grâce au modelage et à l’étayage que lui fournit l’enseignant), afin de collecter des données pour résoudre le problème.

Encore une fois, lorsque l’on plonge dans les métaanalyses ayant servi à fixer l’indicateur de +0,31, il appert que cette méthode est spécialement efficace pour le développement de l’esprit critique (+1,02), l’un des objectifs connexes au développement de la pensée historienne.

Par ailleurs, à l’instar de l’apprentissage par problème, l’enquête favorise en particulier l’apprentissage de procédures (+0,40), mais apparait moins efficace en ce qui concerne l’apprentissage de concepts substantifs (+0,26). Il semblerait aussi que l’enquête favorise l’engagement, la réussite et la transférabilité des apprentissages.

La résolution de problème, la troisième forme d’approche par problème décrite par Hattie (2009), exercerait un effet plus considérable que les deux premières (+0,61). Il s’agit d’un espace d’apprentissage relativement clos dans lequel les élèves doivent identifier les causes d’un problème, trouver une ou des solutions en étudiant la question sous plusieurs perspectives et proposer des interventions avant de les mettre en application et d’en évaluer l’impact.

Cette approche serait surtout efficace chez les enseignants formés à l’utiliser, car elle nécessite une maitrise des euristiques liées à la résolution d’un problème disciplinaire[7]. Encore une fois, il semble que cette approche serait souhaitable dans certaines situations didactiques visant le développement de la pensée historienne.

Quand la science parle en langage statistique, il faut croire son oracle

Tout en gardant à l’esprit les limites inhérentes à ce type de recherche et à celle-ci en particulier, l’analyse plus en profondeur des indices de Hattie (2009) nous permet d’énoncer deux affirmations. D’une part, les approches par problème qu’il a évaluées ne sont pas des méthodes à employer à l’exclusion de tout le reste — et même qu’il convient parfois de les éviter, selon les objectifs poursuivis. D’autre part, les approches par problème sont certainement adaptées au développement des savoirs métahistoriques liés à la pensée historienne, car elles mobilisent des compétences liées à l’esprit critique, ainsi que l’apprentissage de démarches, de protocoles et de procédures. Rappelons que les métaanalyses agrègent des recherches multidisciplinaires, en plus de confondre des méthodologies de tout acabit. Nous voulons aussi revenir sur le flou concernant les étiquettes que Hattie utilise. La division tripartite des méthodes d’enseignement et d’apprentissage par la problématisation nous semble mal justifiée, et donc, artificielle. L’interprétation de ces indices exige donc de la prudence, mais la lecture que nous en avons faite nous autorise à privilégier une démarche d’enseignement-apprentissage centrée sur la résolution de problème pour l’atteinte de nos finalités éducatives.

Notons aussi que Hattie procède à l’analyse de ces techniques dans une perspective fermée. Ainsi, il traite de l’apprentissage par problème, par exemple, sans tenir compte des autres méthodes utilisées en concomitance pour soutenir l’apprentissage: l’usage d’une méthode n’exclut pas l’usage des autres en toutes circonstances. Au bout du compte, il nous semble donc que les statistiques agrégées par Hattie peuvent élargir les perspectives et contribuer à la synthèse des recherches faites en éducation, mais n’invalident pas les approches situées sous l’indicateur de 0,40.

Partant, peut-on qualifier le travail de Hattie de Saint Graal de l’éducation? Ces données offrent-elles des réponses faciles, objectives et absolues parce qu’elles s’appuient sur des nombres?

La réponse est non, bien entendu. Si les données quantitatives agissent souvent comme preuves, il ne faut pas oublier que celles-ci, tout comme les données qualitatives, doivent être interprétées en fonction d’un cadre conceptuel et d’une série d’outils construits afin de répondre à une problématique.

Pour paraphraser Baillargeon (2014) dans son billet, nous pourrions affirmer que non seulement tout le monde œuvrant en éducation doit connaitre les travaux de Hattie, mais aussi que plus d’enseignants d’histoire devraient s’intéresser à un certain nombre de recherches (descriptives/qualitatives et expérimentales/quantitatives) en didactique de l’histoire traitant des processus complexes de manière plus riche que ne le font les données de Visible Learning. Nous en citons quelques-unes dans nos références.

[NDLR] Nous recommandons aux lecteurs intéressés de lire le dossier la revue MJE : http://mje.mcgill.ca/issue/view/559

Références

Baillargeon, N. (2014). Visible Learning. Voir [Montréal]. Repéré à https://voir.ca/normand-baillargeon/2014/02/23/visible-learning/

Bain, R. (2005). ‘They Thought the World Was Flat?’ Applying the Principles of How People Learn in Teaching High School History. Dans How students learn history, mathematics, and science in the classroom. Washington, D.C.: National Academies Press. Repéré à http://site.ebrary.com/id/10075686

Bergeron, P.-J. (2016). Le Saint-Graal des recherches en éducation? Une critique des travaux de John Hattie par un statisticien. Communication présentée au 84e congrès de l’ACFAS, Montréal, Québec. Repéré à http://www.acfas.ca/evenements/congres/programme/84/500/506/d

Dalongeville, A. (2001). L’image du barbare dans l’enseignement de l’histoire: une expérience de l’altérité. Éditions L’Harmattan.

De La Paz, S. et M. K. Felton (2010). Reading and writing from Multiple Source Documents in History: Effects of strategy Instruction with Low to Average High School Writers. Contemporary Educational Psychology, 35 (3), 174‑192.

De La Paz, S., N. Malkus, C. Monte-Sano et E. Montanaro (2011). Evaluating American history teachers’ professional development: Effects on student learning. Theory and Research in Social Education, 39 (4), 494–540.

De La Paz, S., M. Felton, C. Monte-Sano, R. Croninger, C. Jackson, J. S. Deogracias et B. P. Hoffman (2014). Developing Historical Reading and Writing With Adolescent Readers: Effects on Student Learning. Theory & Research in Social Education, 42 (2), 228‑274.

Delacroix, C., Dosse, F., Garcia, P. et Offenstadt, N. (2010). Historiographies, I : concepts et débats. Paris : Gallimard.

Demers, S., D. Lefrançois, D. et M.-A. Éthier (2010). Un aperçu des écrits publiés en français et en anglais depuis 1990 à propos de recherches récentes en didactique sur le développement de la pensée historique au primaire. Dans J.-F. Cardin, M.-A. Éthier et A. Meunier (dir.), Histoire, musées et éducation à la citoyenneté (p. 213-245). Sainte-Foy, Canada: Multimondes.

Didau, D. (2014). Old Hat(tie)? Some things you ought to know about effect sizes. Repéré à http://www.learningspy.co.uk/myths/things-know-effect-sizes/

Éthier, M.-A., J.-F. Cardin et D. Lefrançois (2014). Leur programme et le nôtre. Bulletin d’histoire politique, 22 (3), 165-178.

Hattie, J. (2009). Visible learning: a synthesis of over 800 meta-analyses relating to achievement. London: Routledge.

Guérin-Grataloup, A.-M., M. Solonel et N. Tutiaux-Guillon (1994). Situations problèmes et situations scolaires en histoire-géographie. Revue française de Pédagogie, 106, 25‑37.

Lefrançois, D., M.-A. Éthier et S. Demers (2011). Savoirs disciplinaires scolaires et savoirs de sens commun ou pourquoi des « idées vraies » ne prennent pas, tandis que des « idées fausses » ont la vie dure. Les ateliers de l’éthique, 6 (1), 43‑62.

Martineau, R. (2007). L’approche par problèmes en classe d’histoire. Traces, 45 (2), 8‑9.

Monte-Sano, C. (2011). Beyond Reading Comprehension and Summary: Learning to Read and Write in History by Focusing on Evidence, Perspective, and Interpretation. Curriculum Inquiry, 41 (2), 212‑249.

Monte-Sano, C. et S. De La Paz (2012). Using Writing Tasks to Elicit Adolescents’ Historical Reasoning. Journal of Literacy Research, 44 (3), 273–299.

Monte-Sano, C., S. De La Paz et M. Felton (2014). Implementing a disciplinary-literacy curriculum for US history: learning from expert middle school teachers in diverse classrooms. Journal of Curriculum Studies, 46 (4), 540‑575.

Nokes, J. (2011). Recognizing and addressing the barriers to adolescents’ ‘reading like historians’. The History Teacher, 44 (3). Repéré à http://www.societyforhistoryeducation.org/pdfs/Nokes.pdf

Nokes, J., J. A. Dole et D. J. Hacker (2007). Teaching high school students to use heuristics while reading historical texts. Journal of Educational Psychology, 99 (3), 492‑504.

Ollie Orange 2 (2014). John Hattie admits that half of the Statistics in Visible Learning are wrong. Repéré à https://ollieorange2.wordpress.com/2014/08/25/people-who-think-probabilities-can-be-negative-shouldnt-write-books-on-statistics/

Pontecorvo, C. et H. Girardet (1993). Arguing and reasoning in understanding historical topics. Cognition and Instruction, 11 (3/4), 365‑395.

Reisman, A. (2012). Reading Like a Historian: A Document-Based History Curriculum Intervention in Urban High Schools. Cognition and Instruction, 30 (1), 86‑112.

Snook, I., J. Clark, R. Harker, A.-M. O’Neill, J. O’Neill (2010). Critics and Conscience of Society: A Reply to John Hattie. New Zealand Journal of Educational Studies, 45 (2).

VanSledright, B. (2002). Confronting History’s Interpretive Paradox While Teaching Fifth Graders to Investigate the Past. American Educational Research Journal, 39 (4), 1089‑1115.

Wineburg, S. (2001). Historical thinking and other unnatural acts. Philadelphia: Temple University Press.

[1] Les auteurs veulent adresser leurs remerciements à Sébastien Béland, professeur à l’Université de Montréal, qui a relu cet article et a proposé des modifications.

[2] Lien : https://goo.gl/photos/vdUmFCWAYVaFTp4e7

[3] Lien : http://www.lactualite.com/societe/une-lecture-pour-le-nouveau-ministre-de-leducation/

[4] Lien : http://www.lapresse.ca/debats/chroniques/patrick-lagace/201602/27/01-4955295-si-lecole-etait-importante-9.php

[5] Le biais de publication est une tendance à publier des expériences ayant obtenu un résultat positif plutôt que des expériences ayant un résultat infirmant une hypothèse, voire des résultats simplement non significatifs statistiquement.

[6] Lien : http://visible-learning.org/hattie-ranking-influences-effect-sizes-learning-achievement/hattie-ranking-teaching-effects/

[7] Voir à ce sujet les travaux de De La Paz et ses collaborateurs (De La Paz et Felton, 2010 ; De La Paz, Malkus, Monte-Sano et Montanaro, 2011 ou De La Paz et coll., 2014)

Pingback: Un portrait critique des travaux de John Hattie - RIRE — RIRE